Cet article est aussi disponible en français.

Op 30 november 2022 werd ChatGPT op de wereld losgelaten. De algemene chatbot die kan meepraten over vrijwel alles, brak onmiddellijk door bij een breed publiek. Generatoren voor afbeeldingen, zoals DALL-E en Stable Diffusion, deden daar nog een hele schep bovenop en ondertussen is het wel duidelijk: Generative AI is here to stay. Zelf gingen we er ook direct mee aan de slag, en schreven 10 dagen na de lancering al een artikel over onze eerste bevindingen .

1 jaar later mag de impact van ChatGPT gerust transformatief genoemd worden. Het ecosysteem rond generatieve AI boomt. Wat 3 jaar geleden nog tot het domein van de onrealistische dromen behoorde, werd plots haalbaar en staat vandaag in productie. Talloze start-ups zien het licht: de teller op de website There’s an AI for that is ondertussen de 10.000 gepasseerd, met maart 2023 alleen al goed voor 1209 nieuwe AI-bedrijfjes. Ter vergelijking, voor het volledige jaar 2021 staan er maar 288 start-ups in diezelfde database.

De impact en de snelheid waarmee alles evolueert zorgt ook voor zenuwachtigheid. Zo moet het onderwijs zich in zeven haasten aanpassen aan een nieuwe realiteit. De gemiddelde scholier heeft nu vlot toegang tot technologie die binnen enkele seconden een heel essay kan schrijven – en als South Park er een episode aan wijdt, weet je dat het leeft. Dichter bij huis hebben veel universiteiten ondertussen richtlijnen of adviezen opgesteld over het gebruik ervan (vb. Leuven, Gent, Antwerpen). Die zijn goed doordacht en mogen gerust inspiratiebron zijn voor gelijkaardige richtlijnen bij bedrijven en overheden.

Ook in professionele contexten wordt volop geëxperimenteerd. “Geen idee, maar vraag het eens aan chatGPT” is een typische uitspraak geworden als er nood is aan frisse nieuwe input. Een rondvraag van Nature toonde dat nogal wat wetenschappers de technologie al verkend hebben voor hun werkgerelateerde verplichtingen. In academia wordt luidop de vraag gesteld of het indienen van vuistdikke subsidiedossiers überhaupt nog veel zin heeft, als het schrijven ervan voor automatisering vatbaar is. Gelijkaardige bemerkingen worden ongetwijfeld ook in andere sectoren gemaakt.

Een terugblik

OpenAI blijft de dans leiden, en hun eigen blog geeft een goed beeld van de ontwikkelingen van het afgelopen jaar. Een tijdslijn met enkele sleutelmomenten:

- 17 januari 2023: Microsoft lanceert de Azure OpenAI service, waarmee de OpenAI technologieën beschikbaar worden op Azure,

- 1 februari 2023: Abonnementsdienst ChatGPT Plus biedt voor $20/maand prioritaire toegang tot het (sterk overbevraagde) ChatGPT,

- 1 maart 2023: ChatGPT wordt beschikbaar via API,

- 14 maart 2023: Lancering van GPT-4 voor ChatGPT Plus gebruikers,

- 23 maart 2023: De eerste plugins worden gelanceerd,

- 13 juni 2023: Een updated ChatGPT kan calls naar externe functies opstellen én uitvoeren,

- 20 juli 2023: Met “custom instructions” kan ChatGPT geconfigureerd worden om met bepaalde dingen altijd rekening te houden,

- 22 augustus 2023: Met de Finetuning API kan ChatGPT output worden verfijnd,

- 28 augustus 2023: Lancering van ChatGPT Enterprise,

- 25 september 2023: Gebruikers kunnen spraak en afbeeldingen gebruiken in de conversatie,

- 19 oktober 2023: ChatGPT kan afbeeldingen genereren met DALL-E 3,

- 6 november 2023: Introductie van GPTs waarmee je als leek een custom ChatGPT kan samenstellen die specifieke documenten doorzoekt, en de Assistants API om iets gelijkaardigs te doen als programmeur.

Die laatste zet wordt niet unaniem op gejuich onthaald: veel start-ups in het ecosysteem van generatieve AI hebben net de kern van hun hele business gebouwd rond het concept van Retrieval-Augmented Generation (RAG), en OpenAI gaat daar met hun custom GPTs direct mee in concurrentie. (Kwatongen beweren dat dit meegespeeld zou hebben in de CEO-soap van twee weken later, maar die geruchten zijn vooralsnog niet bewezen).

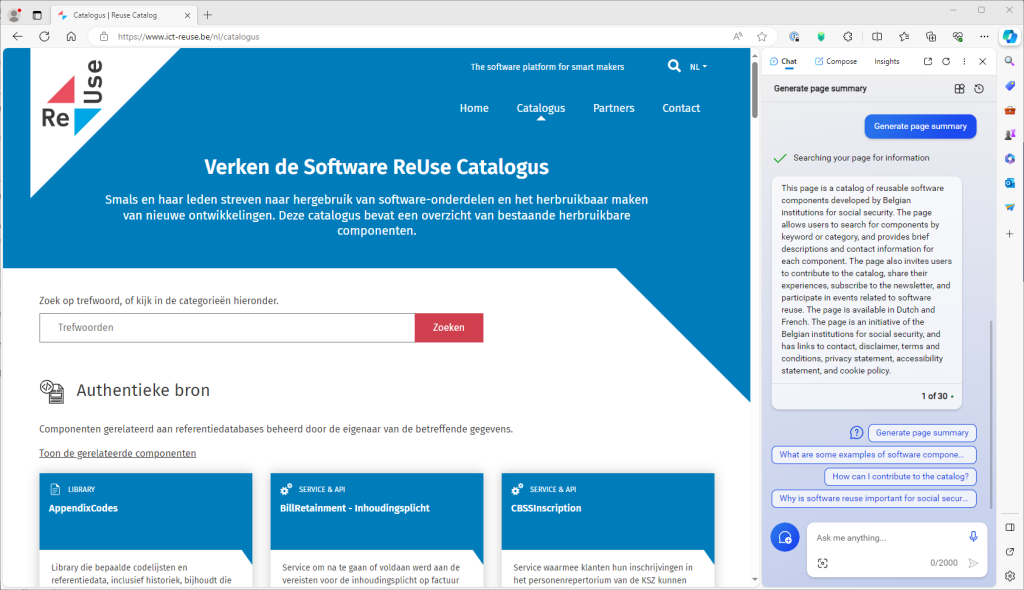

Retrieval-Augmented Generation (RAG), met langchain als populairste library voor developers, is het afgelopen jaar uitgegroeid tot dé manier om Large Language Models te laten inhaken op specifieke, interne of recente informatie. Het idee volgt uit het feit dat de prompt – dit is de opdracht die men geeft aan het taalmodel – ondertussen zodanig lang mag zijn dat er ruimte is om hele bladzijden aan bijkomende informatie toe te voegen. Door de prompt te verrijken met, bijvoorbeeld, de resultaten van een zoekopdracht of de laatste nieuwsberichten, kan een chatbot toch antwoorden formuleren op basis van recente informatie of inhoud van specifieke databases, zonder dat het achterliggende taalmodel daarop getraind hoeft te zijn.

Microsoft was er als de kippen bij om dat om te zetten in de praktijk. Met Bing Chat lanceerden ze een nieuwe conversationele zoekinterface, die voor haar antwoorden de resultaten van Bing Search gebruikt. Het voordeel is dat er transparant bronvermeldingen of referenties bij getoond kunnen worden. We moeten wel alert blijven dat dat nog steeds geen correctheid garandeert: zoekresultaten kunnen nog steeds irrelevant zijn, en samenvattingen foutief of onvolledig. Het product was wel een schot in de roos en Microsoft gaat nu all-in: ondertussen heeft Bing Chat een rebranding ondergaan naar Microsoft CoPilot, is het geïntegreerd in de Edge browser, en is het ook in Windows 11 en Microsoft 365 (het vroegere Office) beschikbaar geworden. Om deze functionaliteit te kunnen benutten, moet in de app de toelating worden gegeven om geopende documenten of webpagina-inhoud te mogen delen met de CoPilot service.

Ook op het vlak van afbeeldingen loopt Microsoft in het koppeloton: De Bing Image Creator biedt (voorlopig) vrije toegang tot de DALL-E 3 generator, en de resultaten ervan worden naadloos geïntegreerd in het nieuwe Microsoft Designer.

Google heeft minder succes met zijn eigen concurrerende Bard. Bij de introductie liep het grondig mis toen Bard met een onjuist feit (een hallucinatie) antwoordde, en de beurskoers van Google klappen kreeg. In vergelijking met OpenAI en Microsoft, lijkt Google minder bezig te zijn met integratie en gebruikerservaring, en eerder haar focus te leggen op de theoretische achtergrond en uitdieping van de technologische mogelijkheden.

Meta wil natuurlijk niet achterblijven en trekt met haar eigen Llama taalmodellen de quasi-open-source-kaart, met nadruk op quasi. Hun focus lijkt vooral te liggen op de individuele developers, voor wie ze het gemakkelijk willen maken om hun taalmodellen te hergebruiken of hertrainen, wat o.a. Stanford deed met haar Alpaca variant. Ze mikken ook op inzetbaarheid op doorsnee hardware, via de succesvolle library llama.cpp, waarmee een model gequantizeerd kan worden: het slim afronden van de parameters van een getraind model voor een kleinere geheugenvoetafdruk, ten koste van een klein maar aanvaardbaar verlies aan precisie. Een quantizatie van 32 bits naar 8 bits, maakt dat een model van 13 miljard parameters geen 52GB maar slechts 13GB RAM vereist. Zo past het volledig in het geheugen van hedendaagse grafische kaarten met 16GB of 24GB vRAM. Gebruiksvriendelijke tools om gequantizeerde modellen op je eigen computer te hosten, zijn GPT4All , MLC, ollama of LMStudio.

Verschillende kleinere bedrijven zitten ook nog in de race en ontwikkelen hun eigen taalmodellen die als backend voor chatGPT-achtige diensten of RAG-toepassingen kunnen dienen. Vermeldenswaardig zijn Anthropic, van ex-OpenAI werknemers, dat vooral de nadruk wil leggen op transparantie en veiligheid, met haar Claude-modellen. Daarnaast kende het Europese Mistral een vliegende start. Met ex-Meta werknemers aan het roer, hanteert het een écht open source model en het gaat zo vooral concurrentie aan met Meta. Voor het Nederlands taalgebied zijn er plannen om, via de onderzoeksorganisatie TNO, een onafhankelijk GPT-NL te ontwikkelen dat ook een alternatief moet vormen voor de grote Amerikaanse spelers, en waarbij de focus moet liggen op het respecteren van de Europese wetten.

Een vooruitblik

Veel bedrijven moeten nog beginnen aan de oefening om hun eigen businessmodellen aan de opkomst van AI aan te passen. We zitten echter nog volop in de beginfase van een sterke groeiperiode voor (generatieve) AI, en het is moeilijk te voorzien wat de volgende jaren zullen brengen. Op de hoogte blijven van de evoluties is een eerste stap. Een uitstekende nieuwsbrief die de vinger aan de pols houdt, is The Batch van DeepLearning.AI, die elke week een bondige samenvatting maakt van de belangrijkste gebeurtenissen in de sector. Wie de kennis wil verbreden en verdiepen, vindt op dezelfde website ook een degelijk cursusaanbod, zoals deze: Generative AI for Everyone . Microsoft heeft een cursus Generative AI for Beginners uitgewerkt die gericht is op developers. Het Finse Elements Of AI heeft een van de meest toegankelijke gratis cursussen voor een algemeen publiek, en er zijn er nog vele andere.

Bedrijfsleiders en beleidsmakers worden vandaag al geconfronteerd met al deze nieuwe ontwikkelingen op de werkvloer of in de administratie, en willen hierop een antwoord formuleren – of toch minstens een gedragscode ontwikkelen. De beleidsmonitor van het Kenniscentrum Data en Maatschappij verzamelt voorbeelden in binnen- en buitenland die als inspiratie kunnen dienen, voor wie het warm water niet opnieuw wil uitvinden. Het Britse AI Standards Hub verzamelt relevante publicaties over industriestandaarden met betrekking tot AI. Op een abstracter internationaal niveau is o.a. de OESO actief bezig met monitoring. Het zich snel veranderende landschap maakt het wetgevend werk zeker niet gemakkelijker. Op Europees niveau loopt de verwachte AI act alleszins vertraging op. Dit weerhield Stanford er niet van om de bestaande grote spelers al eens te evalueren op basis van de ontwerptekst die nu voorligt.

Ondertussen houdt niets een bedrijf of overheid tegen om al aan de slag te gaan en te experimenteren met de technologie. Het blijft daarbij wel belangrijk om niet te hard van stapel te lopen en het gezond verstand niet overboord te gooien. ChatGPT is geen mirakeloplossing. Geen enkele hoeveelheid veiligheidsmechanismes kan garanderen dat een taalmodel niet zou hallucineren of compleet verzonnen tekstjes zou presenteren als feiten. Van veel taalmodellen zijn de trainingsdatasets geheim, maar we weten wel dat ze zo groot zijn dat er onmogelijk een nauwkeurige selectie en filtering op gebeurd kan zijn. LLMs zijn vandaag black boxes; de oorsprong van een bepaalde woordkeuze in een antwoord is niet te achterhalen. Dit alles maakt ze logischerwijs ongeschikt om er klakkeloos kritische toepassingen op te bouwen. Het is evident dat het een slecht idee zou zijn om, zonder enige supervisie, medische gegevens te laten verwerken door een taalmodel dat deels getraind is op willekeurig van het net geplukte teksten van samenzweringstheoretici, antivaxers, instagram-influencers, homeopaten en andere kwakzalvers.

Over kwakzalverij gesproken, met de regelmaat van de klok duiken nu ook doemdenkers op, die in een opbod voor aandacht, met steeds groteskere uitspraken op de proppen komen, tot aan het voorspellen van het uitsterven van de mens toe. (Het omgekeerde bestaat ook: mensen die geloven dat utopia nabij is.) De disproportionaliteit van zulke uitspraken alleen al, getuigt van weinig kennis van zaken én weinig voeling met de realiteit. Alle vooruitgang ten spijt, zijn we immers nog mijlenver verwijderd van het punt dat een robot zelfs maar uw kleren kan strijken. Clowneske claims leiden de discussie wel af van de problemen die vandaag in de echte wereld opduiken: misbruik zoals deepfakes, vergroting van de digitale kloof, een gebrek aan mogelijkheden om automatische beslissingen aan te vechten, het gebruik van data zonder toelating of bronvermelding, etc. Allemaal zaken waar de nodige aandacht naartoe moet blijven gaan, en waar Europa een actieve voortrekkersrol speelt. Dat hoeven geen blokkerende factoren te zijn, want ook met beide voetjes op de grond is er geen gebrek aan opportuniteiten.

In een recent opiniestuk oogstte Bill Gates veel bijklank voor zijn visie op de evolutie in de nabije toekomst. Die is dat chatbots verder evolueren naar “agents“, d.w.z. dat ze ook een (beperkte) autonomie krijgen om actie te ondernemen, eventueel gesuperviseerd. Waar Co-Pilots nog onderdeel zijn van een applicatie, zou ook dat generieker worden, met de bedoeling dat toekomstige agents over applicaties heen kunnen werken, zoals personal assistants. Inderdaad is er nog heel wat werk te verzetten voor het zover is: protocollen die apps toelaten beter met elkaar te communiceren, manieren om veilig data uit te wisselen terwijl de privacy wordt gevrijwaard, …

Tot slot blijft de afhankelijkheid van enorme en niet-transparante modellen (GPT-3, GPT-4) bij een externe clouddienst, een moeilijke pil om te slikken wanneer er interne of gevoelige gegevens verwerkt zouden kunnen worden. Het is onvoorspelbaar welke gegevens een doorsnee gebruiker zou kunnen meedelen aan een chatbot, en bij CoPilot-achtige plugins is het vaak moeilijk terug te vinden welke gegevens de plugin meeleest en achter de schermen doorstuurt. De GDPR stelt echter wel strenge en concrete eisen. Beloftes in gebruikersvoorwaarden of zelfs contractuele afspraken dat ontvangen data niet zal worden opgeslagen of hergebruikt, zijn niet voor iedereen voldoende om plots blind vertrouwen te hebben.

Het voor de hand liggende alternatief is het lokaal deployen van kleinere modellen. De kwaliteit van de output daarvan is echter navenant lager, en dat stelt teleur als hoge verwachtingen gecreëerd door chatGPT het referentiepunt zijn. Kleinere modellen missen de vlotte meertaligheid van ChatGPT, en werken nog met veel compactere prompts, wat de uitbouw van RAG-apps ermee limiteert. Er wordt ijverig en in verschillende richtingen gezocht naar manieren om die kloof te dichten. Zo wordt er verder geïnnoveerd in manieren om kleinere modellen efficiënter te finetunen (specialiseren) voor een specifieke taak. Ook het concept van distilleren – het comprimeren van een model – oogt veelbelovend. Er zijn indicaties dat betere resultaten behaald kunnen worden door te trainen op weinig maar kwalitatieve en correcte data, in plaats van op veel rommelige en mogelijke foutieve data. Verder blijft het voor elke applicatie, zoeken naar goede balansen qua modelkeuze, prompt engineering, finetuning, en RAG.

Het speelveld ligt dus nog helemaal open en er is er volop ruimte voor innovatie. We mogen zeker nog verdere verbeteringen verwachten op korte termijn. Er komt ongetwijfeld opnieuw een razend interessant jaar aan!

______________________

Dit is een ingezonden bijdrage van Joachim Ganseman, IT consultant bij Smals Research. Dit artikel werd geschreven in eigen naam en neemt geen standpunt in namens Smals.

Leave a Reply