Snel een tekstje vertalen is de laatste jaren een makkie geworden, zeker als 100% accuraatheid niet hoeft – met dank aan Google/Bing Translate, Deepl, of de speciaal voor publieke administraties ontwikkelde eTranslation tool van de EU. Voor professionele vertalers verandert de snelle opkomst van zulke technologieën hun jobinhoud. Vertaalmotoren gebaseerd op neurale netwerken (zie ook een vorige blogpost) krijgen een plek in professionele CAT-omgevingen (Computer Assisted Translation), naast reeds bestaande hulpmiddelen zoals de Translation Memories, waarmee eerder gemaakte vertalingen hergebruikt kunnen worden. Zo verschuift de taak van de vertaler meer richting supervisie: nalezen en corrigeren waar nodig, en tussenkomen op vlakken waar vertaalmotoren problemen hebben: homoniemen, spreekwoorden, woordgrappen, emotionele nuance, stijlkenmerken, culturele referenties enz. Het spreekt voor zich dat beëdigde vertalingen nog altijd onder eindverantwoordelijkheid van een mens moeten vallen.

Bij simultaanvertalers ligt dat nog anders. Zij werken onder hoge tijdsdruk: een vertaling moet bijna in real-time geproduceerd worden. Toekomstige context of verduidelijkingen kunnen nog ontbreken op het moment van vertalen. Tolken gebeurt, gegeven deze beperkingen, eerder op een “best effort” basis. De benodigde vaardigheden zijn dusdanig verschillend dat ook de opleidingen tot tolk of vertaler fundamenteel anders ingericht worden.

De technologische vooruitgang inzake vertaalmotoren is uiteraard de tolken niet ontgaan. Simultaanvertaling is bovendien belangrijk: denk aan internationale vergaderingen, diplomatiek overleg, ondertiteling van live debatten op televisie, etc. Om daar een bestaande vertaalmotor voor te gebruiken, die enkel tekst naar tekst vertaalt, moet je eerst nog spraak correct kunnen omzetten naar tekst. Dat is het domein van de speech-to-text (STT) engines – maar die hebben hun eigen beperkingen, waar we vorige maand al over schreven.

Google gooide dan ook hoge ogen bij het voorstellen van de Interpreter modus van Google Translate, die ondertussen naadloos is ingewerkt in smart speakers en mobiele apps met Google Assistant. Microsoft volgde op de voet met hun Translator, die ook vergaderingen tussen meerdere personen kan begeleiden, waarbij iedereen in de eigen moedertaal toegesproken wordt. Niet van plan onder te doen, gooiden ze er gelijk plugins voor o.a. Powerpoint tegenaan, waarmee een presentatie live ondertiteld kan worden in een andere taal – gegeven dat de spreker duidelijk articuleert en standaarduitspraak hanteert. Ook moderne hardwarematige vertaalcomputers kregen al updates om spraakherkenning te integreren en gebruik te maken van cloud-based vertaalmotoren.

Een blik achter de schermen

Zo goed als alle van deze “tolk”-apps werken momenteel in dialoogvorm. Het systeem wacht totdat een zin volledig is uitgesproken voordat een vertaling begonnen wordt. Een belangrijke motivatie hiervoor is het verschil in woordvolgorde tussen talen: soms moet het einde van de zin afgewacht worden om het begin van de zin in een andere taal te kunnen vormen. Neem dit voorbeeld, vertaald met Deepl:

- Ik ben afgelopen zaterdag nog snel even naar Antwerpen gegaan

- Je me suis rendu rapidement à Anvers samedi dernier

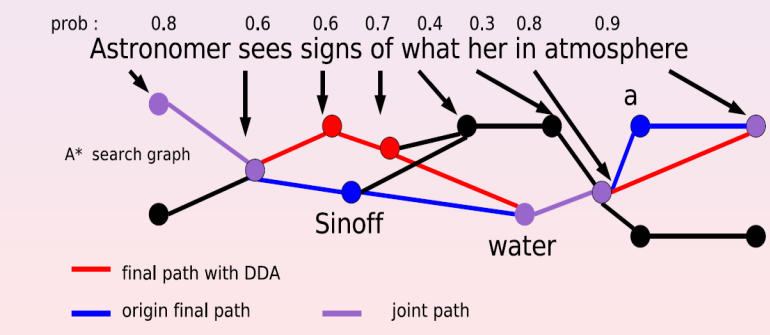

Als men echt zo weinig mogelijk vertraging of latency wil bekomen, en nog voor de zin helemaal is uitgesproken al een aanzet van vertaling wil geven, dan moet men toelaten dat een vertaling achteraf nog aangepast kan worden. Na machine translation van een tekst is minimaal eenmalig een post-editing stap doen – eventueel ook deels automatisch – sowieso een goed idee. Wil men automatisch gaan simultaantolken dan is een trade-off te maken: hoe minder latency men toe wil laten, hoe groter het risico dat men meermaals de reeds vertaalde woorden zal moeten herwerken.

Achter de schermen doen Automatic Speech Recognition engines dat ook al bij de transcriptie van de audio: al naargelang er bijkomende fonemen worden herkend wordt telkens herberekend wat het meest waarschijnlijke woord is dat uitgesproken wordt.

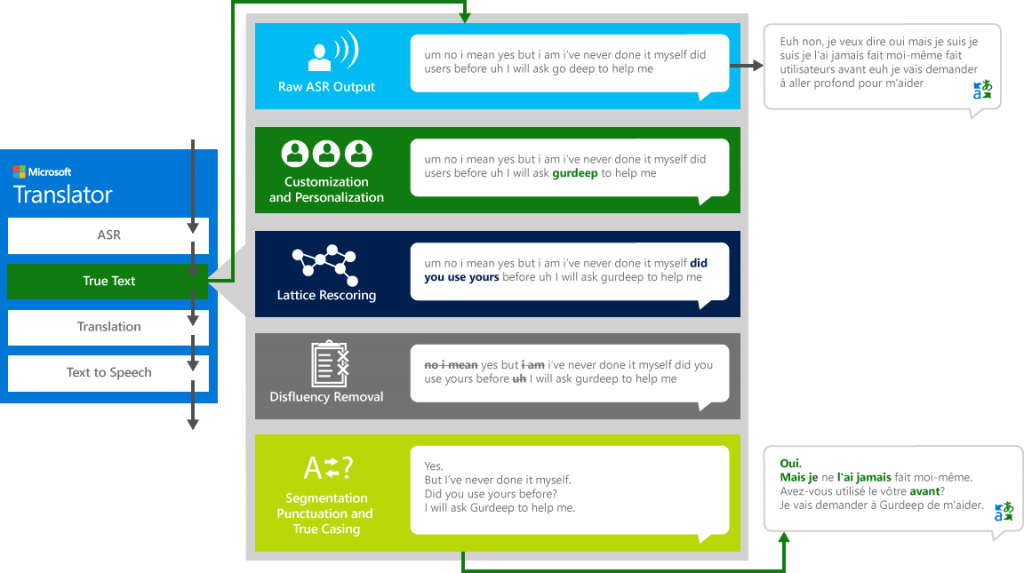

Bij elke automatische transcriptie van audio, of bij ondertiteling, zijn ook segmentatie en filtering (bvb het weglaten van “euh” en andere stopwoorden) belangrijke problemen die in een editing-fase opgelost moeten geraken – zoals duidelijk te merken in deze demonstratie van BBC R&D. Ook getwijfel, herhalingen, e.a. zijn erg courant in natuurlijke spraak maar wil je niet terugzien in een transcriptie of een daaropvolgende vertaling. Misschien wil je ook bepaalde entiteiten zoals eigennamen of datums correct herkennen. Microsoft vatte dat alles samen in het volgende diagram van een speech-to-speech vertaalsysteem:

In de praktijk

Toch worden er al moedige pogingen ondernomen om dit in de praktijk om te zetten. Een veelbelovend uitgewerkt concept is deze automatische ondertitelaar / vertaler voor hoorcolleges op de universiteit. Een demofilmpje van het systeem vind je hier – je ziet er duidelijk ook de automatische post-editing aan het werk, waardoor de vertaling regelmatig een update krijgt, wat moeilijk te volgen kan zijn voor de gebruiker als dat vaak gebeurt. Het klaslokaal is een relatief ideale omgeving voor dit soort toepassing, want men kan ervan uitgaan dat een professor duidelijk articuleert en enigszins standaardtaal hanteert om zichzelf verstaanbaar te maken, en dat het publiek veelal zwijgt. Dan nog zijn er allerlei obstakels te overwinnen.

De stand van de technologie vandaag met Nederlands als brontaal, en in een minder ideale omgeving, kan je aan het werk zien door de ondertiteling te activeren in dit Nederlandstalig filmpje op YouTube en dan een vertaling naar een andere taal in te schakelen via de opties “Instellingen -> Ondertiteling -> Automatisch vertalen”. Het is duidelijk dat fouten bij de initiële spraaktranscriptie leiden tot bijkomende fouten bij de vertaling achteraf, waarin plots hele stukken wegvallen. Het gebruik van dialect (zoals te zien als je voor dit filmpje hetzelfde doet) zorgt al helemaal voor een nonsensicaal resultaat – en probeer gerust eens enkele willekeurige andere filmpjes uit.

End-to-end speech-to-text vertaling, waarbij de spraaktranscriptie wordt geïntegreerd met vertaling, wordt wel actief onderzocht in academische context (zie bvb deze recente paper, of de Google Translatotron), en de resultaten benaderen stilaan die van cascaded systemen. Het vergt echter grote hoeveelheden specifiek voor dat doel geannoteerde data (zoals deze), wat verdere snelle vooruitgang danig hypothekeert. Ook het evalueren van vertaalmoteren is onderwerp van debat – wanneer is een vertaling “beter” dan een andere? Daarover uitweiden zou ons hier te ver leiden, maar de geïnteresseerde lezer vindt hier een uitgebreide introductie.

Er bestaan wel kleinere hulpmiddelen die tegemoetkomen aan specifieke deelproblemen van het tolken. Deze focussen bijvoorbeeld op de onmiddellijke herkenning van individuele woorden terwijl iemand spreekt. InterpretBank is zo’n hulpmiddel dat jargon of andere moeilijke terminologie detecteert en onmiddellijk de correcte vertaling ervan voorschotelt aan de simultaanvertaler. Die laatste hoeft dan geen specialist meer te zijn in het gespreksonderwerp en heeft direct de exacte vertaling voorhanden van keywords.

Wie zelf aan de slag wil met componenten voor spraakherkenning, postprocessing en machine translation, kan de zoektocht beginnen bij projecten zoals Mozilla Deepspeech, CMUSphinx of MarianNMT. Datasets om vertaalmotoren te trainen zijn o.a. te vinden op OpenSLR.org .

Conclusie

Op dit moment zijn “cascade”-systemen, waarbij aparte spraakherkenning-, vertaling, en spraaksynthesecomponenten aan elkaar worden geschakeld, de meest robuuste methodes voor speech-to-speech vertaling. Het probleem van de woordvolgorde is relatief fundamenteel. Er zal bijna altijd een vertraging van een zinslengte moeten toegestaan worden als men een robuuste automatische vertaling wilt maken die achteraf geen grote aanpassingen meer moet ondergaan – ook bij geïntegreerde speech-to-speech systemen. Ook in de nabije toekomst zal volautomatisch tolken dus nog wel een tijdje turn-based blijven. Immers, hoe dichter men echt real-time functioneren wil benaderen, hoe meer missers men moet tolereren.

De auteur wenst Joan Van Poelvoorde, vertegenwoordiger RSZ bij de federale G-clouddienst Babelfed, en prof. dr. Bart Defrancq, hoofd van de tolkopleidingen van de UGent, te bedanken voor hun waardevolle input in de aanloop naar het schrijven van dit artikel.

______________________

Dit is een ingezonden bijdrage van Joachim Ganseman, IT consultant bij Smals Research. Dit artikel werd geschreven in eigen naam en neemt geen standpunt in namens Smals.

Leave a Reply